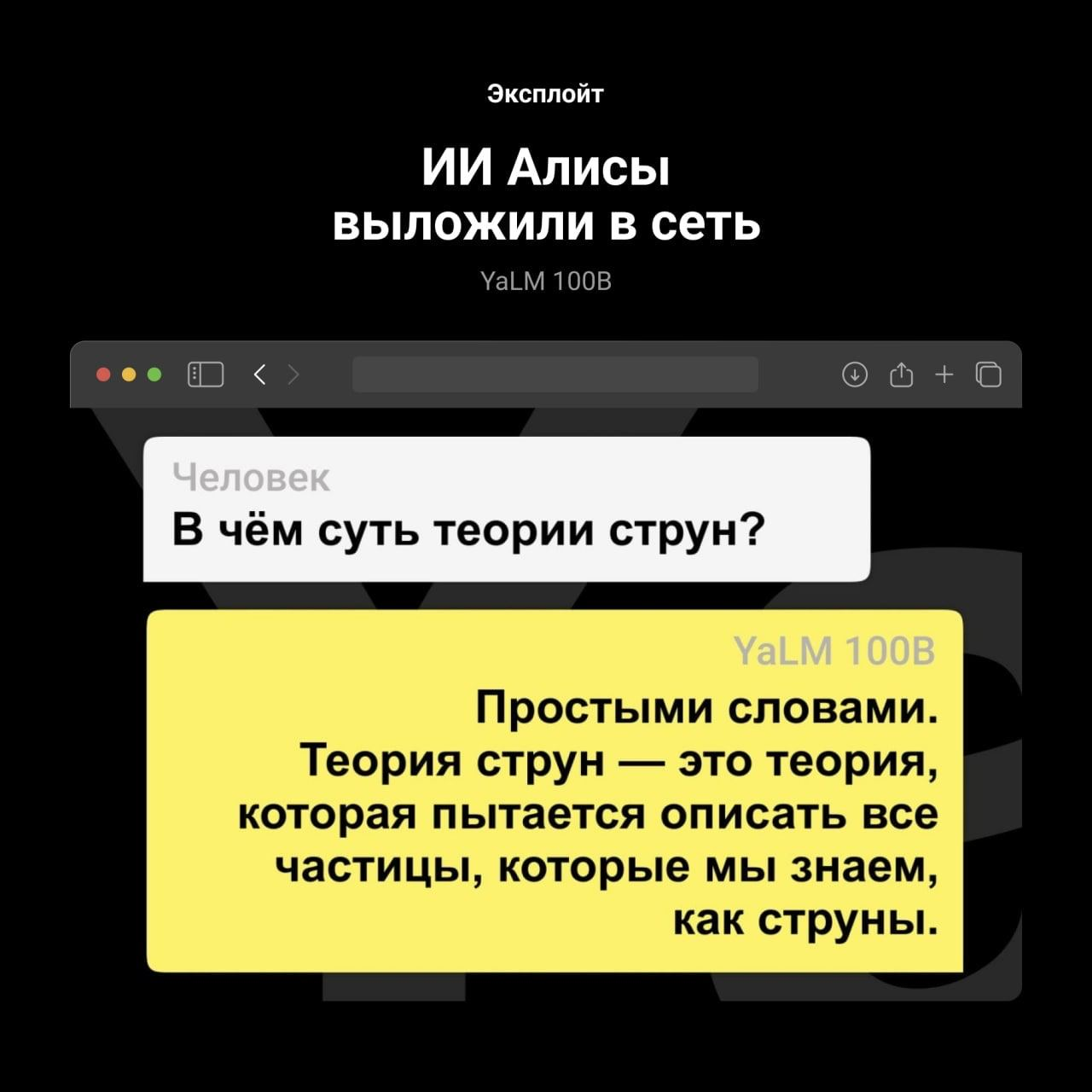

Вчера Meta* выложили свою модель на 66 млрд. параметров, и объявила её крупнейшей, но меньше чем за сутки этот рекорд был побит Яндексом. Речь о языковой модели YaLM 100B на 100 млрд параметров. Модели YaLM применяются, например, в Алисе.

YaLM 100B обученна на почти 2 ТБ русских и английских текстов. Причём не только на Википедии/новостных статьях/книгах, но и на коде и научных статьях.

Теперь исходный код доступен на Github, а на Хабре можно почитать об истории создания и обучения. Спойлер: без суперкомпьютеров не обошлось.

*запрещённая в РФ организация

Join the conversation.